03 / 2023

Da svariati mesi stiamo sperimentando le intelligenze artificiali su diversi fronti (visivo, testuale, sonoro) e le usiamo attivamente come supporto al nostro lavoro quotidiano di creazioni creative.

Ma con il crescere dell’utilizzo di AI come Midjourney, DALL-E, Stable Diffusion, Chat GPT ecc. è doveroso capire meglio alcune dinamiche di questi strumenti (e anche qualcosa in più dei loro creatori).

Quando vi diciamo che le Intelligenze Artificiali sono lo specchio della nostra società, è la verità in senso letterale.

Riflettono esattamente i concetti, le ideologie politiche, le pratiche culturali di chi le programma (sapete dove si trova il quartier generale di Midjourney? A San Francisco ovviamente), e quindi anche della nostra società.

O per lo meno, di quella fetta di società che ha accesso alle tecnologie.

Abbiamo dedicato del tempo a questo tema, indagando i cosiddetti bias cognitivi dell’intelligenza artificiale.

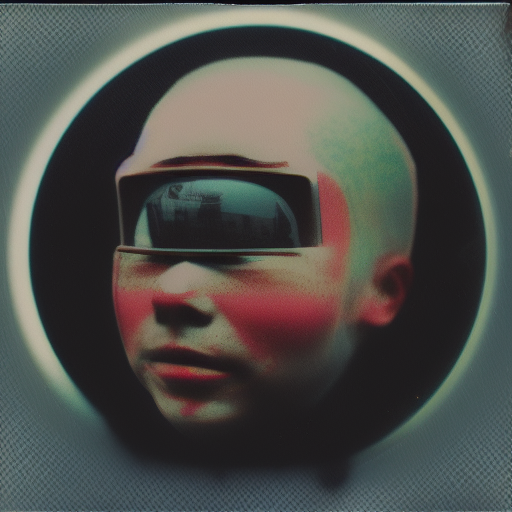

Parlando di AI, EMOZIONI E PREGIUDIZI, ve la ricordate Empat.IA? Ecco un video per rinfrescarvi la memoria.

Empat.IA è la nostra installazione, attualmente di base a Lipsia, che indaga come una AI interpreta le emozioni o sentimenti e concetti di natura prettamente umana.

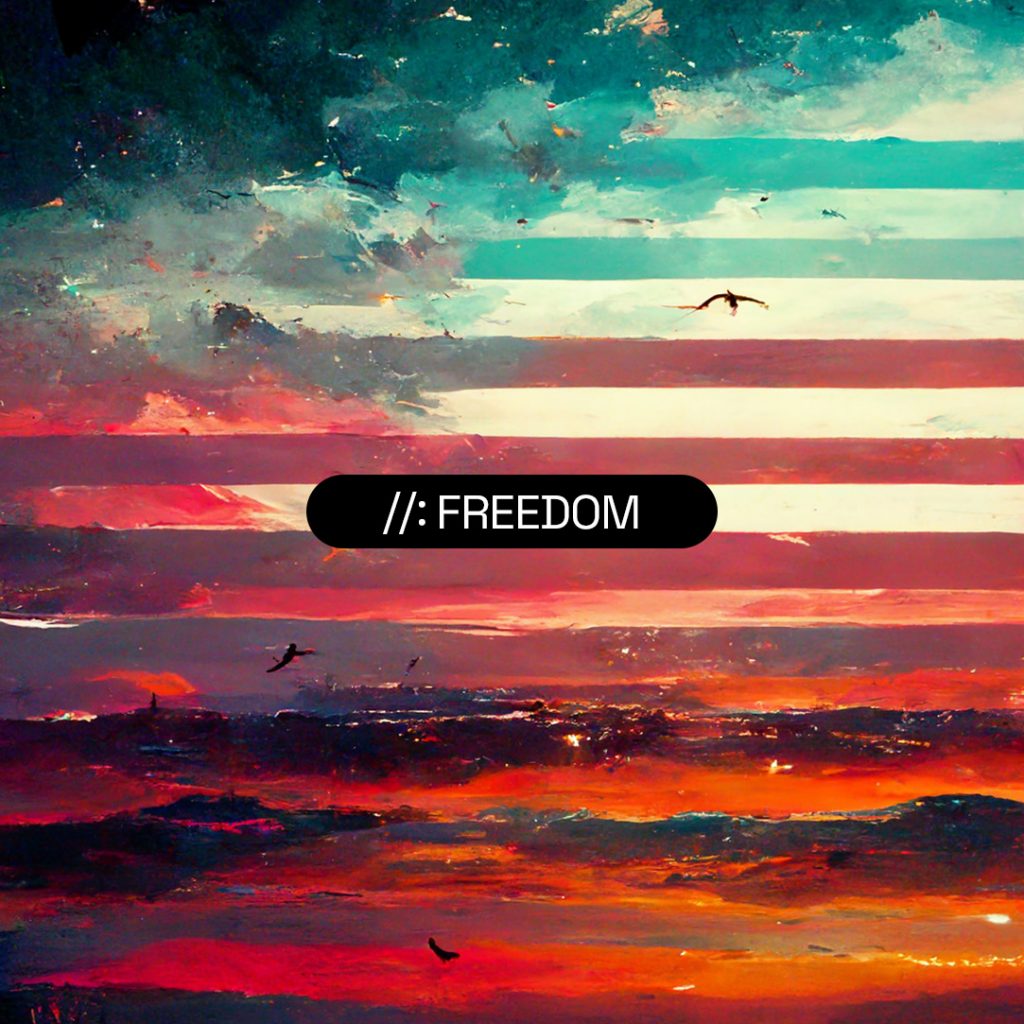

Abbiamo prodotto tantissime immagini dividendole per diversi topic: rabbia, amore, amicizia, libertà…

Non abbiamo dato alcun input stilistico: volevamo che la macchina avesse massima libertà interpretativa, per restituirci il concetto nel modo più vero e completo per i suoi canoni.

Esteticamente le immagini prodotte non erano particolarmente accattivanti. Ma sulla larga scala, qualche risultato interessante è saltato fuori.

Libertà secondo Midjourney: chiari riferimenti alla bandiera americana.

La parola relationship è rappresentata con un uomo e una donna.

Il pianto è rappresentato da una figura femminile. Boys don’t cry.

Recentemente anche Wired, in collaborazione con TBWA (una nota agenzia di comunicazione), ha pubblicato un interessante progetto sui bias cognitivi dell’intelligenza artificiale: un bel lavoro per mettere in luce i pregiudizi delle AI.

Date un’occhiata al progetto qui.

Per comprendere meglio il perché del nostro progetto, ed anche quello di Wired, per capire in generale l’importanza dell’argomento AI, EMOZIONI E PREGIUDIZI (le AI sono già uno strumento usatissimo e non possiamo ignorare il fatto che in futuro diventeranno parte integrante della nostra vita quotidiana), bisogna fare un passo indietro e spiegare cosa sono i bias cognitivi.

I bias cognitivi nell’intelligenza artificiale (IA) sono distorsioni o pregiudizi presenti nei modelli e negli algoritmi di IA.

Ad esempio, se un modello di IA è addestrato su un insieme di dati che rappresenta in modo non equo una determinata razza o genere, potrebbe mostrare pregiudizi razziali o di genere nella sua capacità di classificare ed elaborare.

L’IA è il risultato delle conoscenze, delle esperienze e dei pregiudizi dei suoi sviluppatori, che sono incorporati nei suoi algoritmi e nei suoi modelli.

Per approfondire l’argomento, vi suggeriamo questo articolo

Esiste una soluzione al problema?

Bhe, qualcosa si può fare.

Innanzitutto, è importante che vengano selezionati dataset per istruire le AI che siano diversi e rappresentativi.

Inoltre, sarebbe utile la creazione di modelli per individuare eventuali pregiudizi, in modo da realizzare dei test di verifica dei bias.

A riguardo, date un’occhiata a questo strumento sviluppato da IBM, AI Fairness 360, per mitigare i bias dei modelli di machine learning.

In sintesi, un’intelligenza artificiale può essere considerata uno specchio dei suoi creatori, ma è anche molto di più.

È uno strumento potente che può influire sulla società e sulle persone in molti modi, e pertanto è importante che sia progettata e utilizzata in modo responsabile.

PS

Nella prossima newsletter, vi mostreremo un po’ delle nostre sperimentazioni realizzate in queste ultime settimane, e soprattutto, come stiamo utilizzando le AI per scopi creativi.